DeepSeek 是杭州深度求索人工智能基础技术研究有限公司 (成立于2023年7月17日) 研发的推理模型,该模型采用强化学习进行后训练,旨在提升推理能力,尤其擅长数学、代码和自然语言推理等复杂任务。2025年1月20日,DeepSeek 正式发布 DeepSeek-R1 模型,并同步开源模型权重。在部署 DeepSeek 之前,需要安装 Ollama , Ollama 是大型语言模型框架,可以理解为AI模型的宿主,如果需要美观的 UI 界面,需要安装其他应用配合,本教程我们通过部署 OpenWebUI 应用来运行 DeepSeek-R1 模型。

Open WebUI 简介

是一款可扩展的、功能丰富的用户友好型自托管 Web 界面,旨在完全离线运行。它支持包括 Ollama 和与 OpenAl 兼容的 API 在内的多种 LLM 运行器。

Open WebUI 的主要特点

轻松设置:支持 Docker 和 Kubernetes 安装,提供便捷的映像管理。

API 集成:兼容 Ollama 和 OpenAI API,自定义 API URL,适配多个 LLM 服务如 LMStudio 和 OpenRouter。更多详情请查阅 Open WebUI 官方文档。

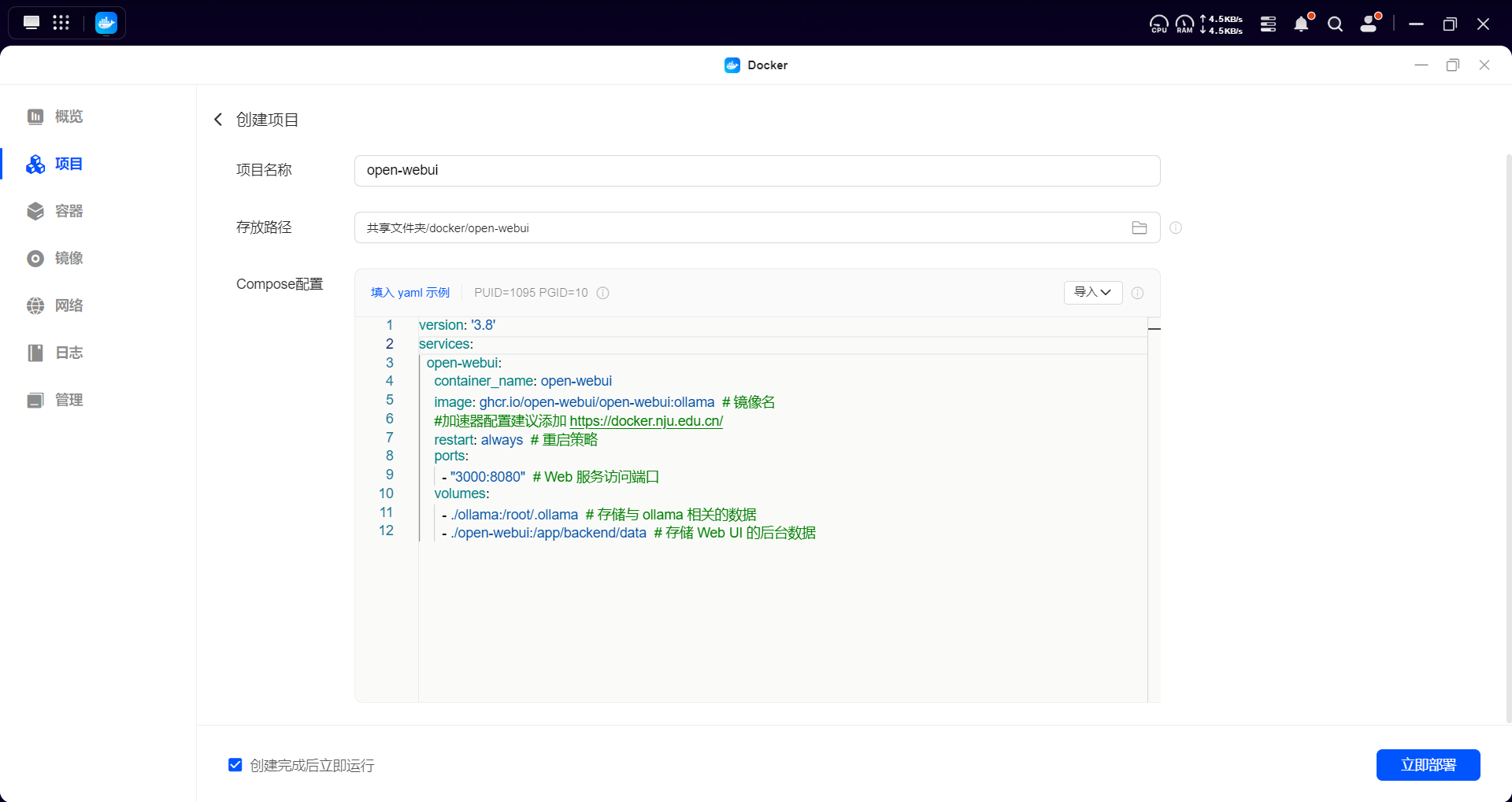

在 UGOS Pro 系统上,推荐使用项目 Docker Compose 快速部署容器,适合需同时管理多个容器的场景,这种方法简化了容器的部署与管理工作。以下是使用 Docker Compose 部署 OpenWebUI 的详细步骤。

在 UGOS Pro 系统中,打开 Docker 应用,点击【项目】 > 【创建】,启动项目创建向导。

在项目创建向导中,上传以下 OpenWebUI 的 Docker Compose 配置文件:

的后台数据en-webui:/app/backend/data # 存储 Web UI 的后台数据

注意:

./ 表示当前 Docker Compose 文件所在的目录;

冒号前是 NAS 的存储路径,冒号后是容器内的映射路径。

镜像来源:使用 ghcr.io/open-webui/open-webui:ollama 镜像,该镜像已集成了 OpenWebUI 和 Ollama,因此无需单独运行 Ollama 服务,系统将自动完成启动与集成。

端口设置:OpenWebUI 默认端口为 8080,但可通过 ports 参数调整。本文将其映射到 3000 端口,访问地址为 http://NAS_IP:3000。Ollama 的默认端口为 11434,但无需暴露,因为镜像内部已完成对接,OpenWebUI 可直接调用 Ollama 服务。

相关阅读

【FAQ】如何在 Docker Compose 配置文件中正确表示 volumes 挂载路径?

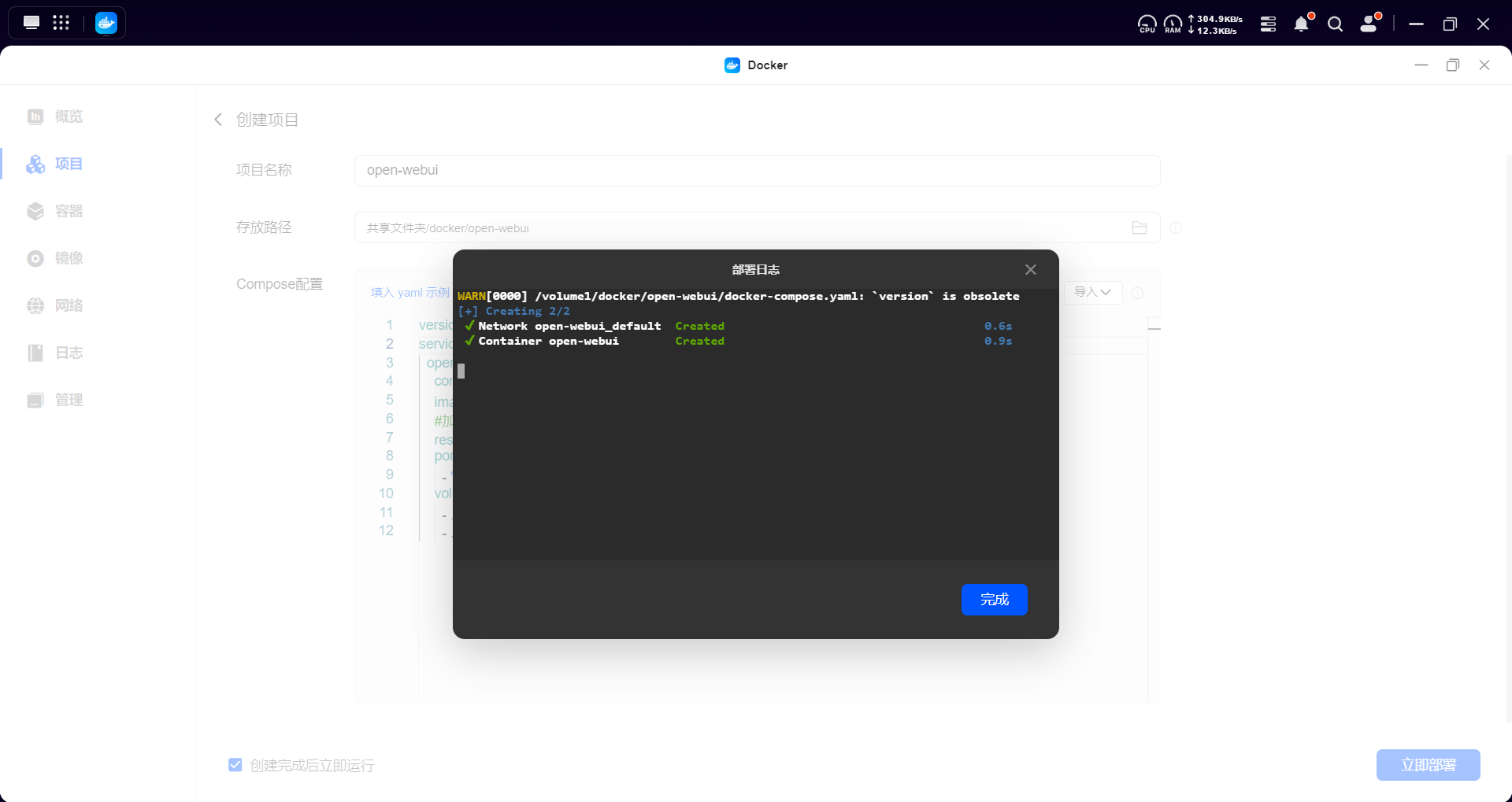

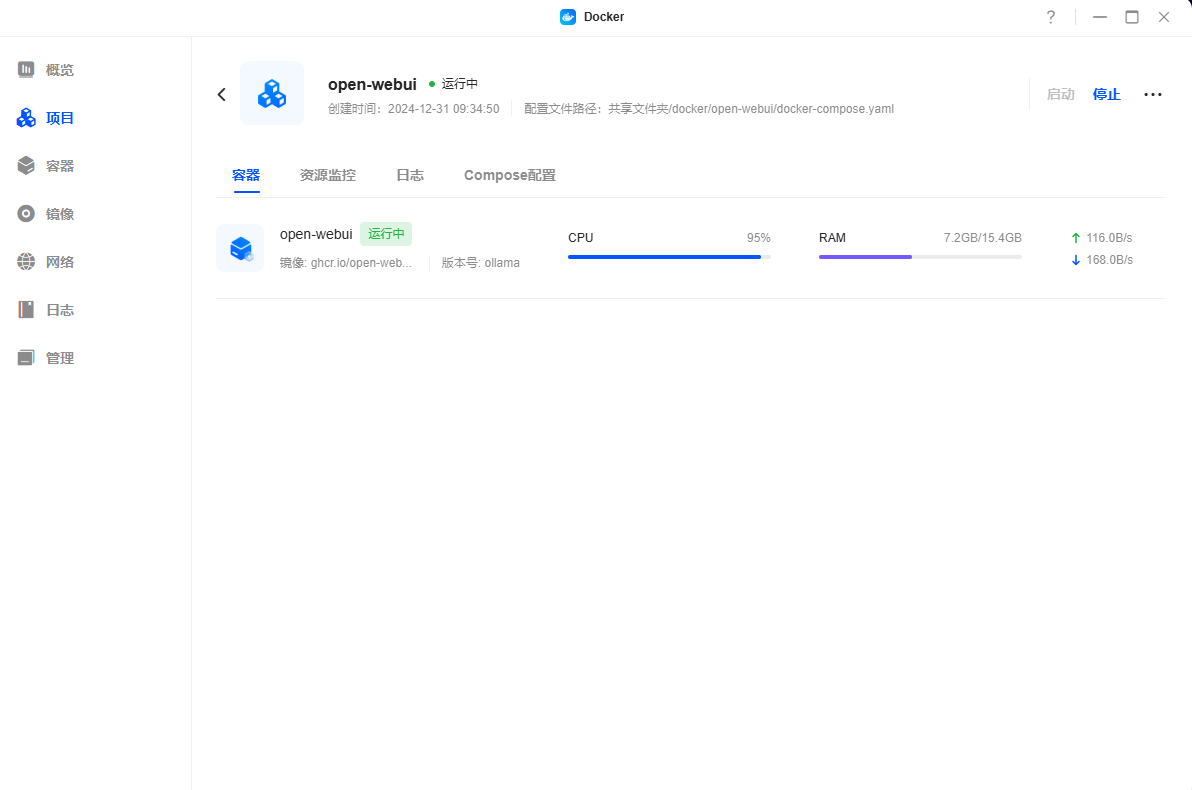

上传配置文件后,点击【立即部署】,系统会自动拉取镜像并启动容器。

镜像下载失败处理方法:

open-webui镜像拉取失败:建议配置加速器以提高镜像下载速度,特别是在中国内地的网络环境下。 详细操作步骤请参考《Docker配置镜像加速和镜像源》了解如何设置。

代理设置:在某些情况下,您可能需要配置 HTTP/HTTPS 代理来辅助下载,详见《Docker通过设置代理下载镜像》。

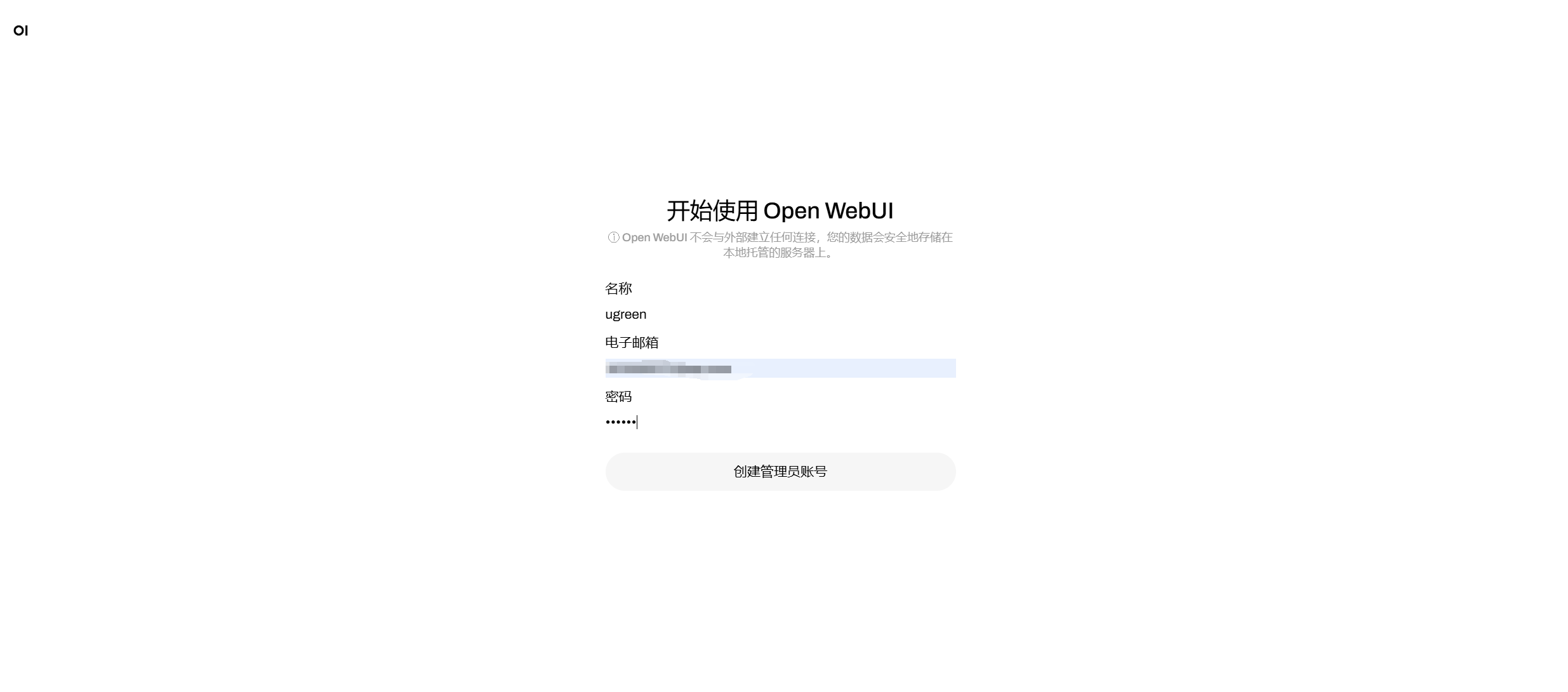

要访问 Open WebUI 的 Web 界面,请按以下步骤操作:

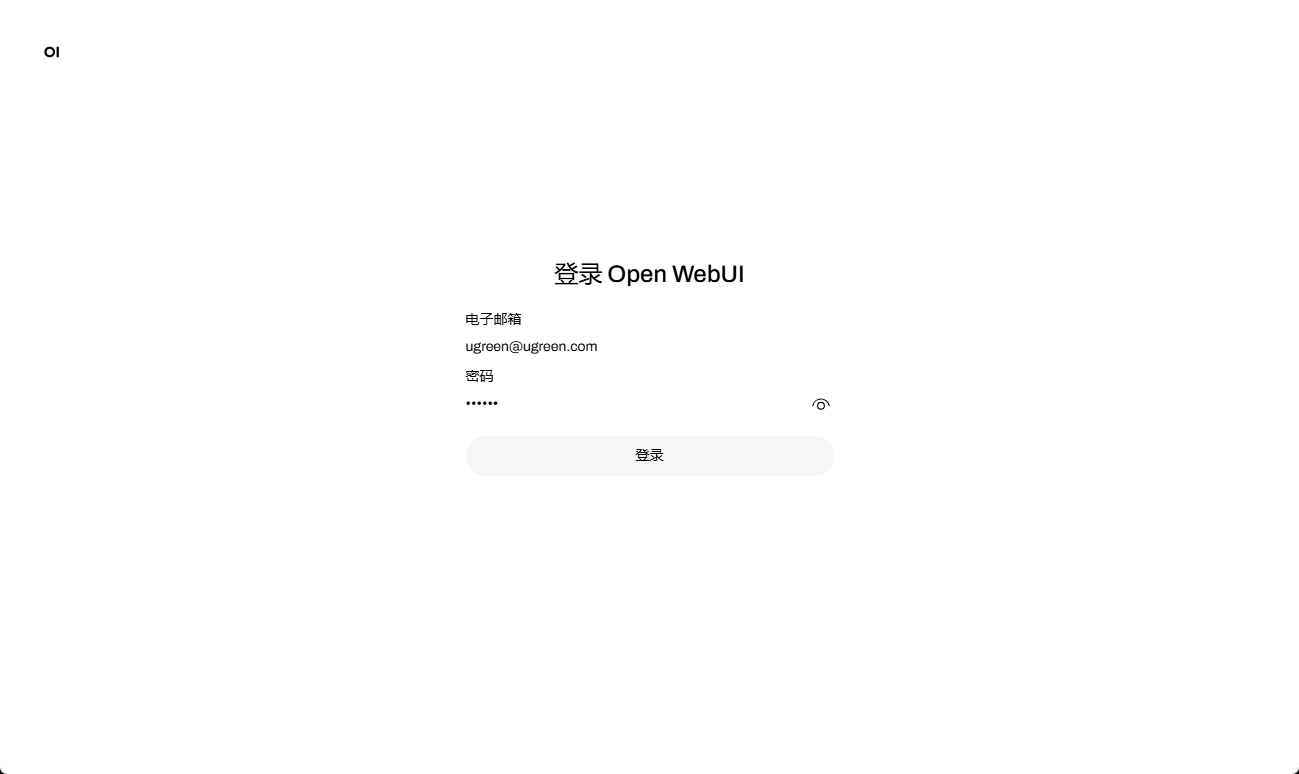

局域网内打开浏览器,访问部署地址,进入登录页面后点击开始使用。

初次访问需创建管理员账号,设置用户名、邮箱及密码。

使用新建的账号登录。

注意:初次访问页面时,可能会遇到内部错误或连接被拒的情况,请稍候分钟再尝试加载。

界面空白问题的解决方法

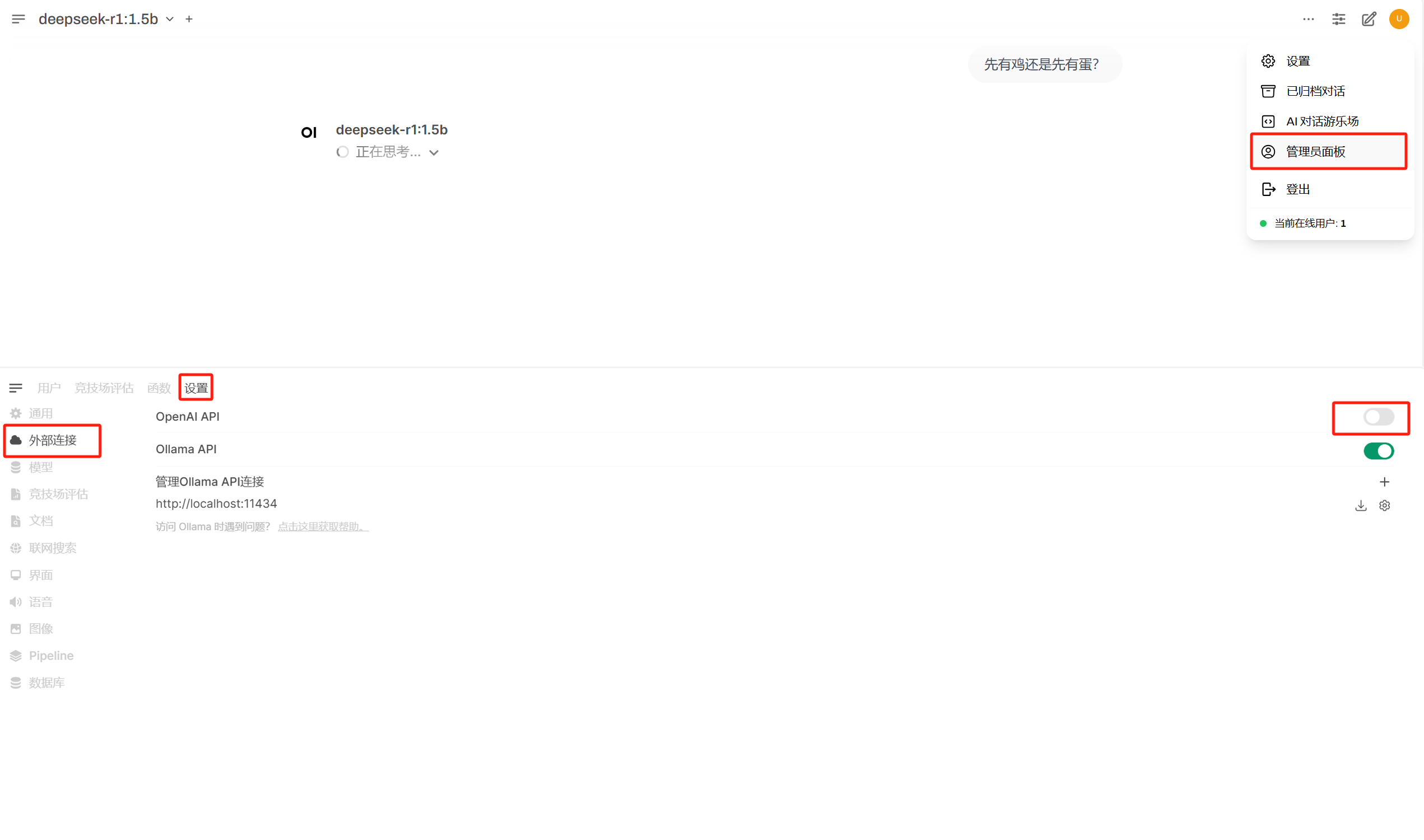

初次登录 Open WebUl 时您会遇到界面空白的情况。这是因为系统在后台等待 OpenAl 模型的返回数据时产生了延迟。如果您不希望等待加载过程,可以通过关闭 OpenAI API 来解决该问题。请注意,关闭OpenAI API需要在首次加载界面成功后进行。

在首次加载 open webui 界面成功后,可以在【管理员面板>设置>外部连接】里将 OpenAl 的 API 选项关掉,再重新打开页面即可。

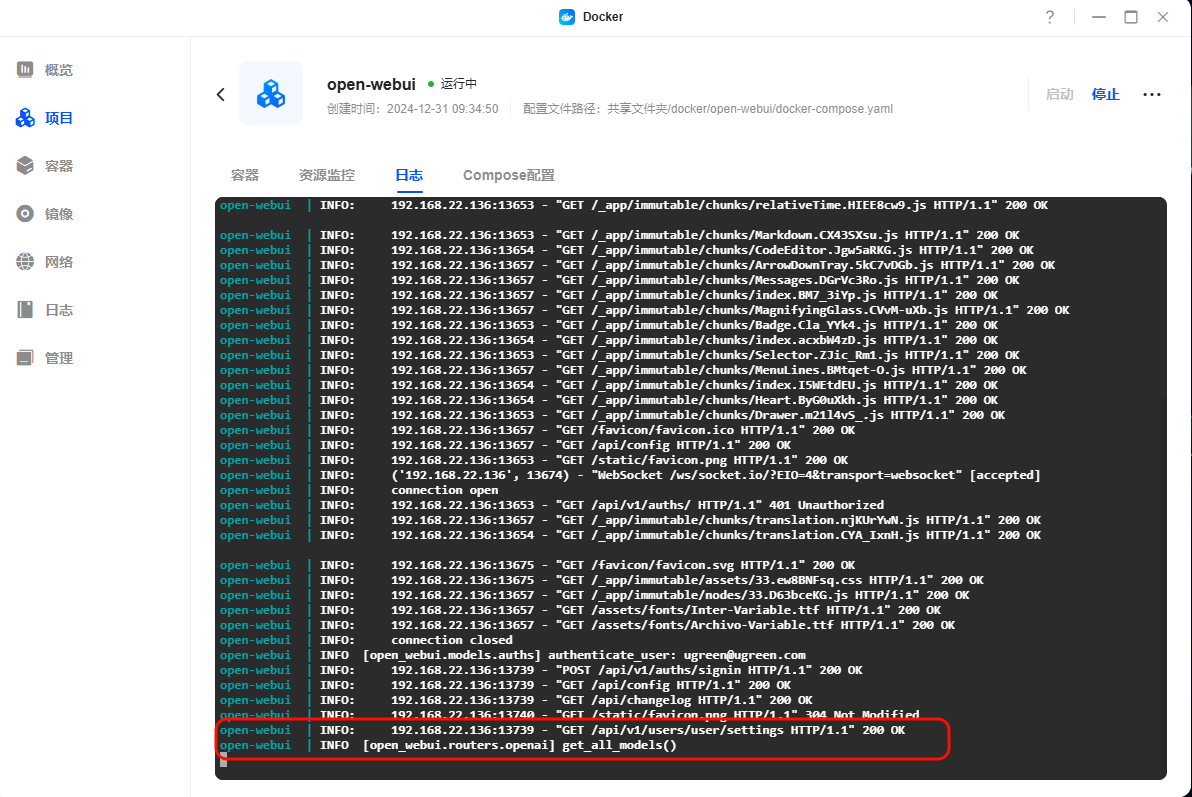

您还可以通过查看相关日志文件来判断加载过程是否正常进行。具体操作如下:

进入 UGOS Pro 的 Docker 应用。

点击【容器】 > 选中 Open WebUI 容器 > 点击【日志】。

请检查日志中是否包含模型加载的进度信息,如 "get_all_models" 或 "Loading models" 等提示。若日志显示正常加载,请等待1-2分钟,页面将自动刷新并恢复正常;若出现错误提示,则根据日志信息进行问题排查。

成功登录后,将进入主界面。

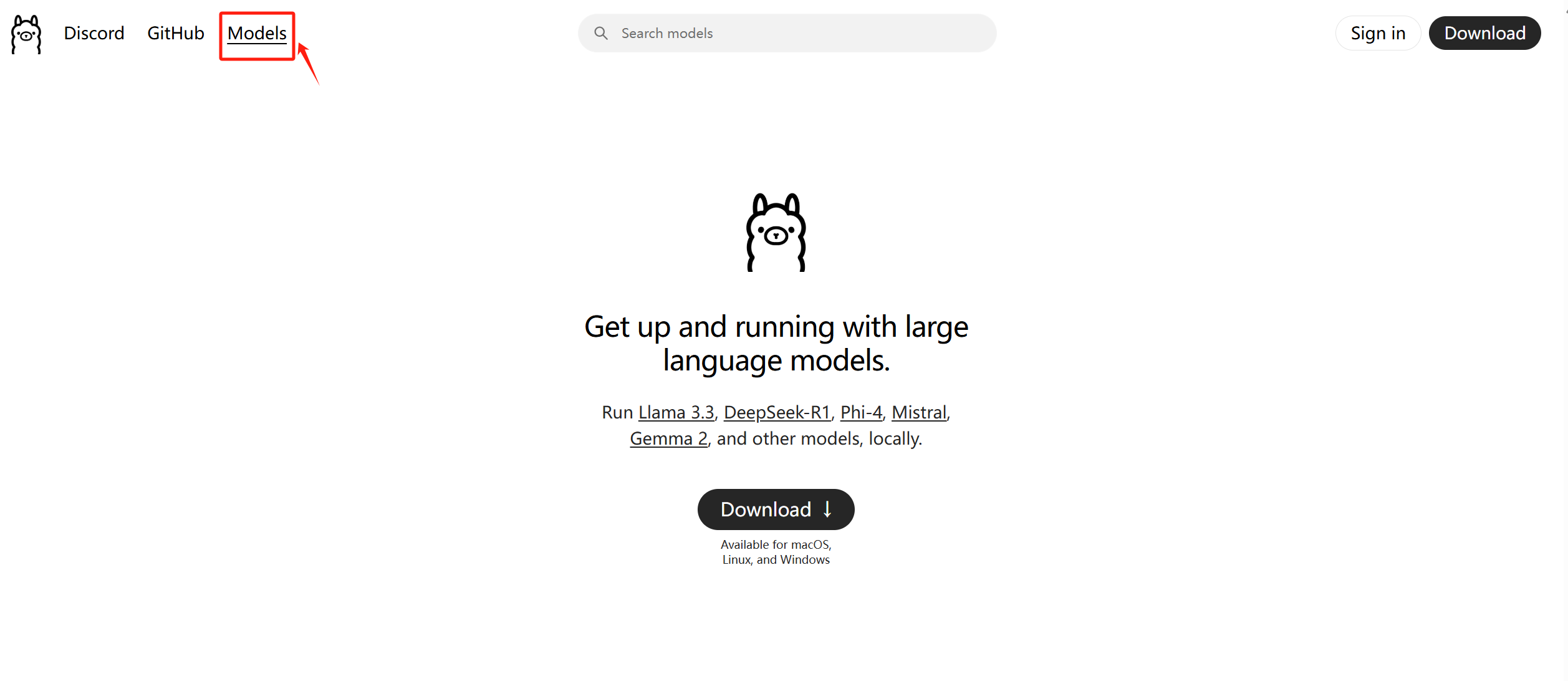

1.前往 Ollama 官网:https://ollama.com下载模型,点击左上角 “Models” 。

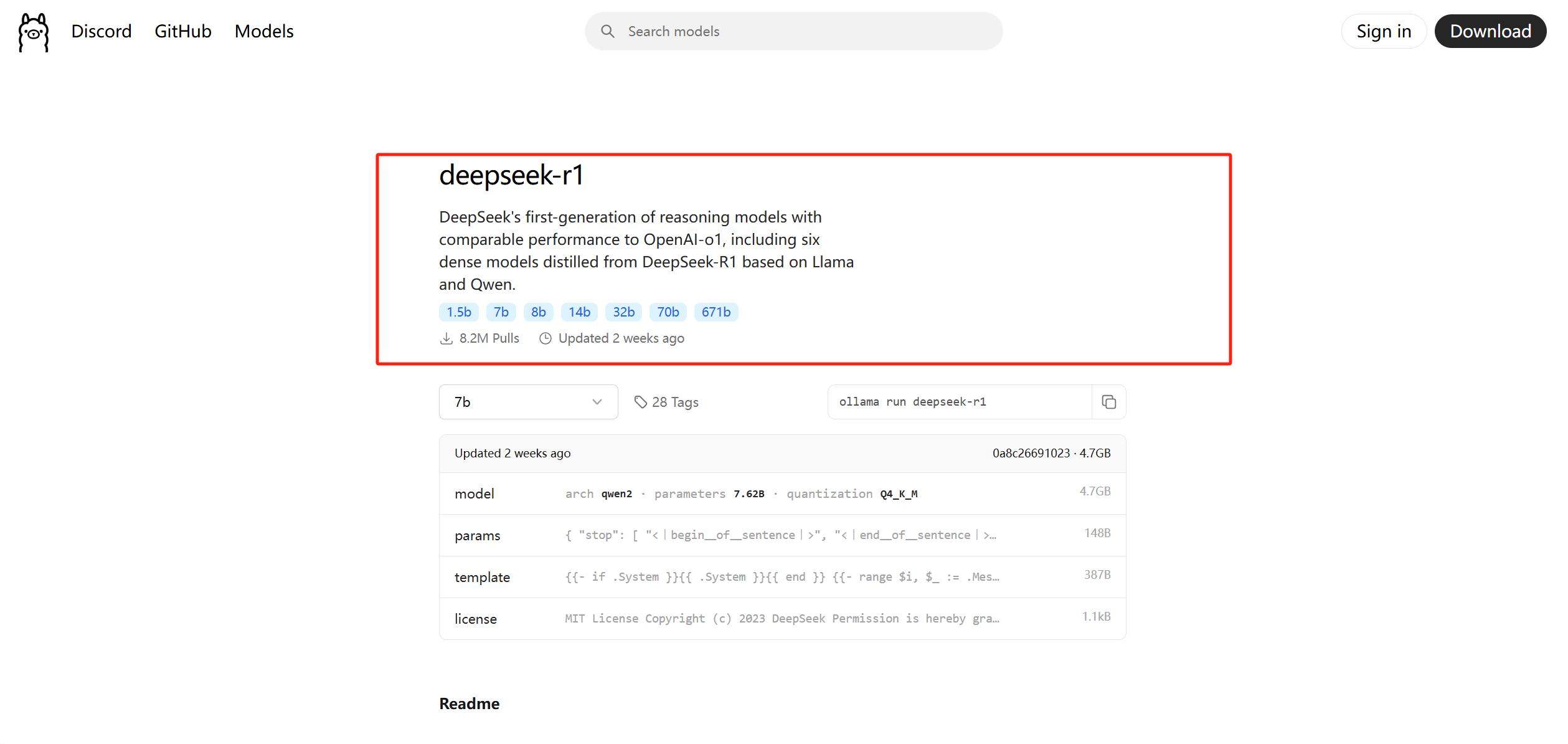

2.选择“deepseek-r1”模型,点击进入查看详情。

DeepSeek-R1各版本硬件要求和使用说明:

1.5b 大小的模型通常至少需要 8GB RAM,针对边缘设备上的快速推理进行优化的轻量级版本。

7b 大小的模型通常至少需要 16GB RAM,适用于通用推理任务的平衡模型。

8b 大小的模型通常至少需要 32GB RAM,有更高的准确性和更好的上下文理解。

14b 大小的模型通常至少需要 64GB RAM,推理和解决问题的能力得到提高。

32b 大小的模型通常至少需要 128GB RAM,更强的逻辑分析和更精细的逐步输出。

70b 大小的模型通常需要至少 256GB RAM,适用于高级人工智能驱动应用程序的高端版本。

671b 大小的模型通常需要至少 512GB RAM ,专家混合 (MoE) 模型,每个令牌激活 370 亿个参数,以实现最先进的推理性能。

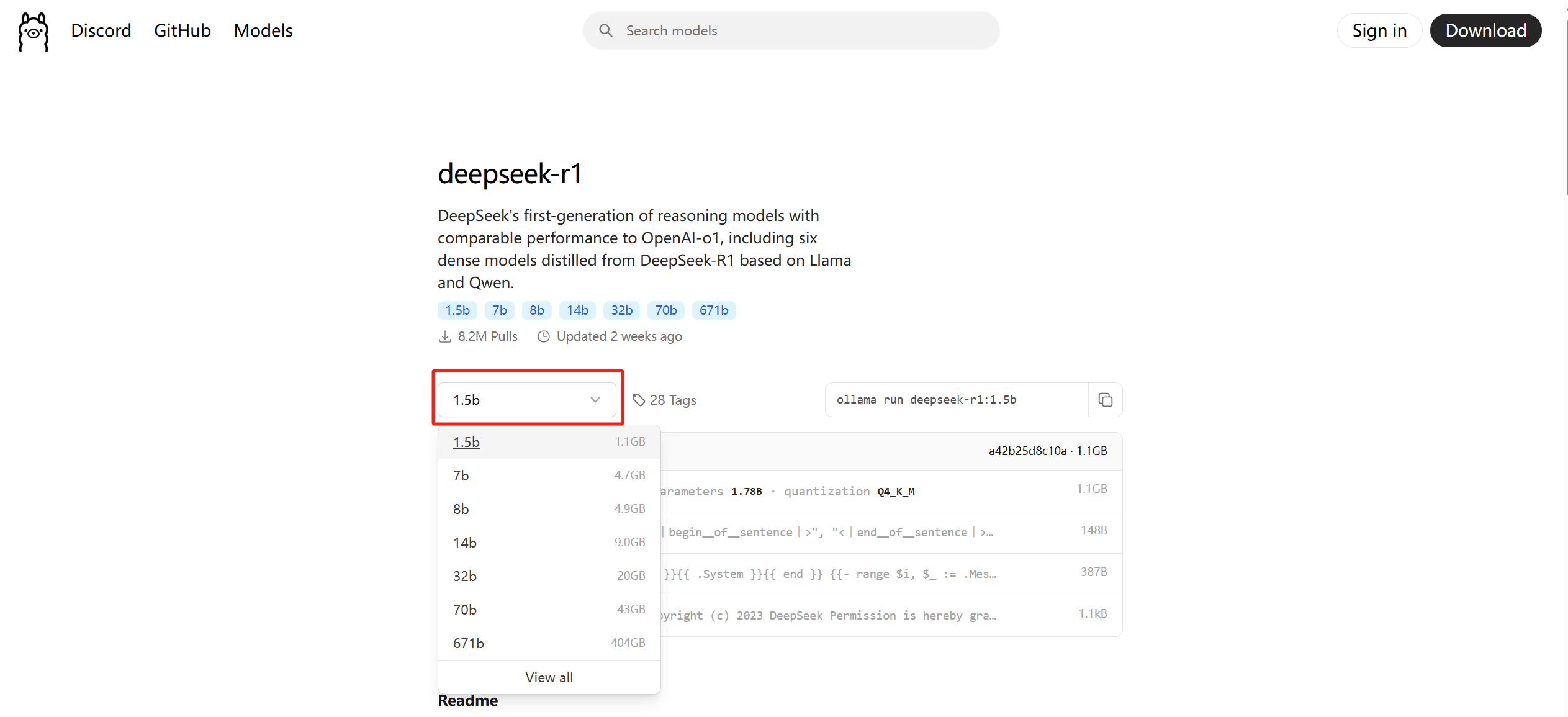

3.这里根据 NAS 硬件配置选择模型大小,不指定的话默认是 7B,本教程我们选择 1.5 B 大小的模型。

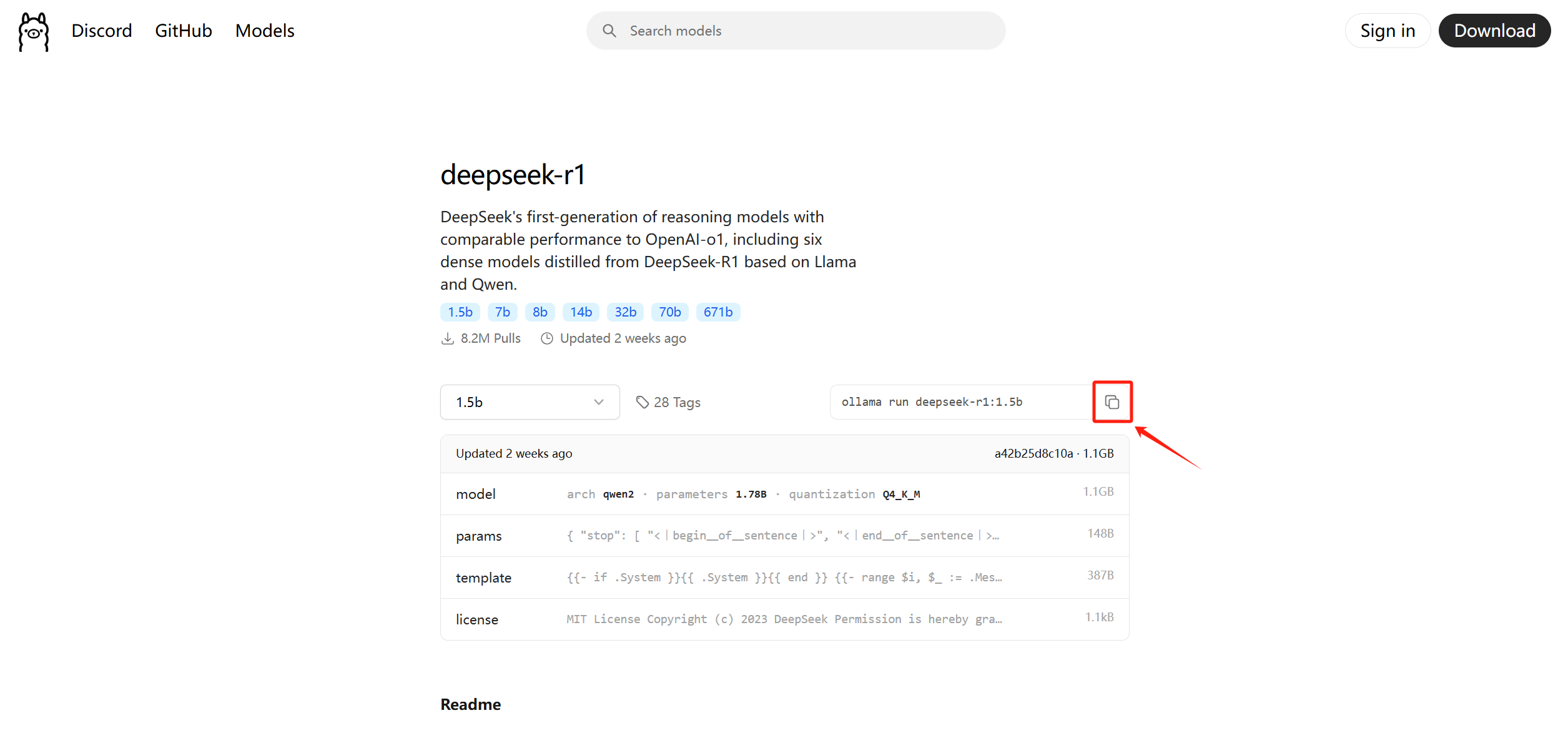

4.复制旁边的拉取命令ollama run deepseek-r1:1.5b

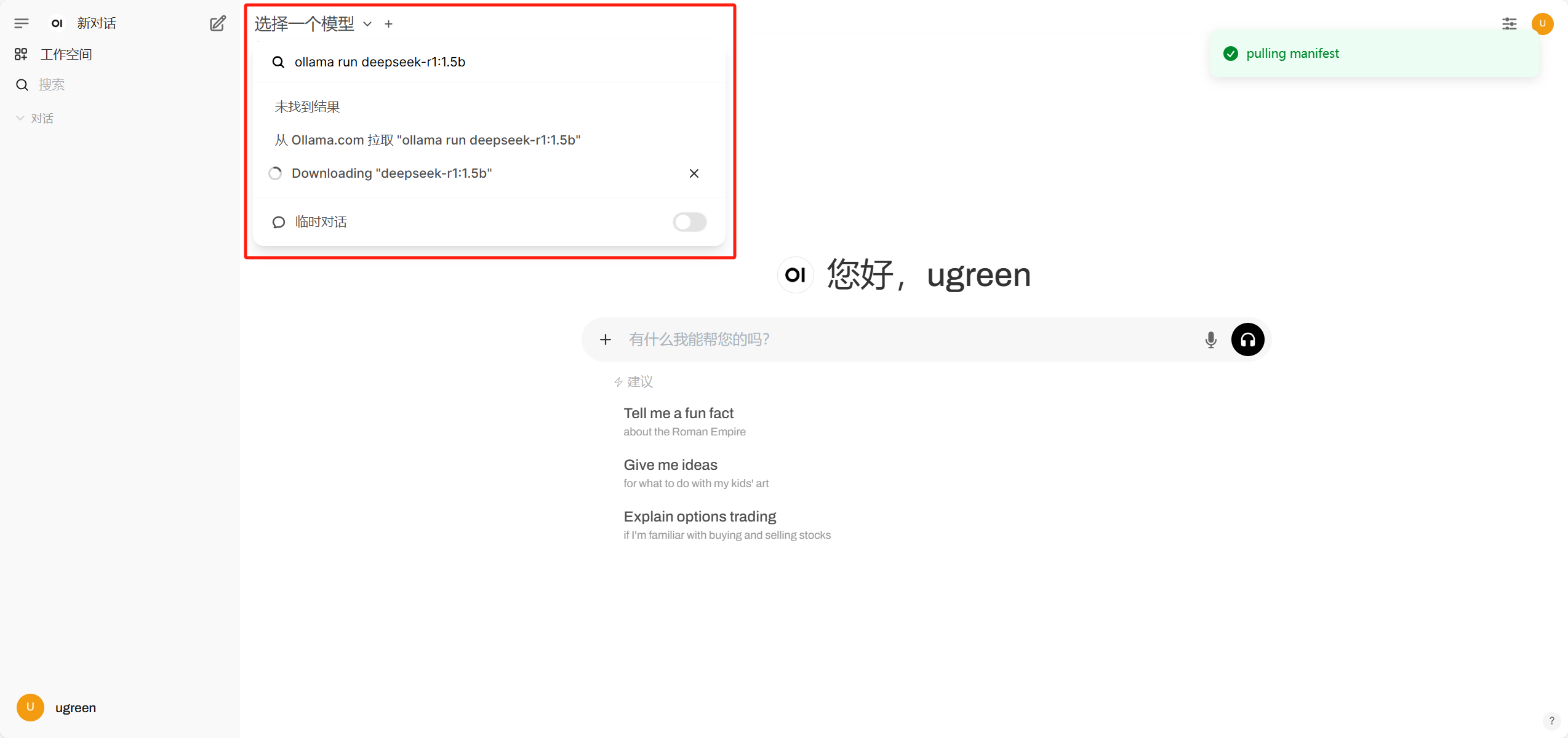

登录 Open WebUI 的 Web 界面,点击左上角搜索输入模型名称(例如: ollama run deepseek-r1:1.5b) 直接下载使用。

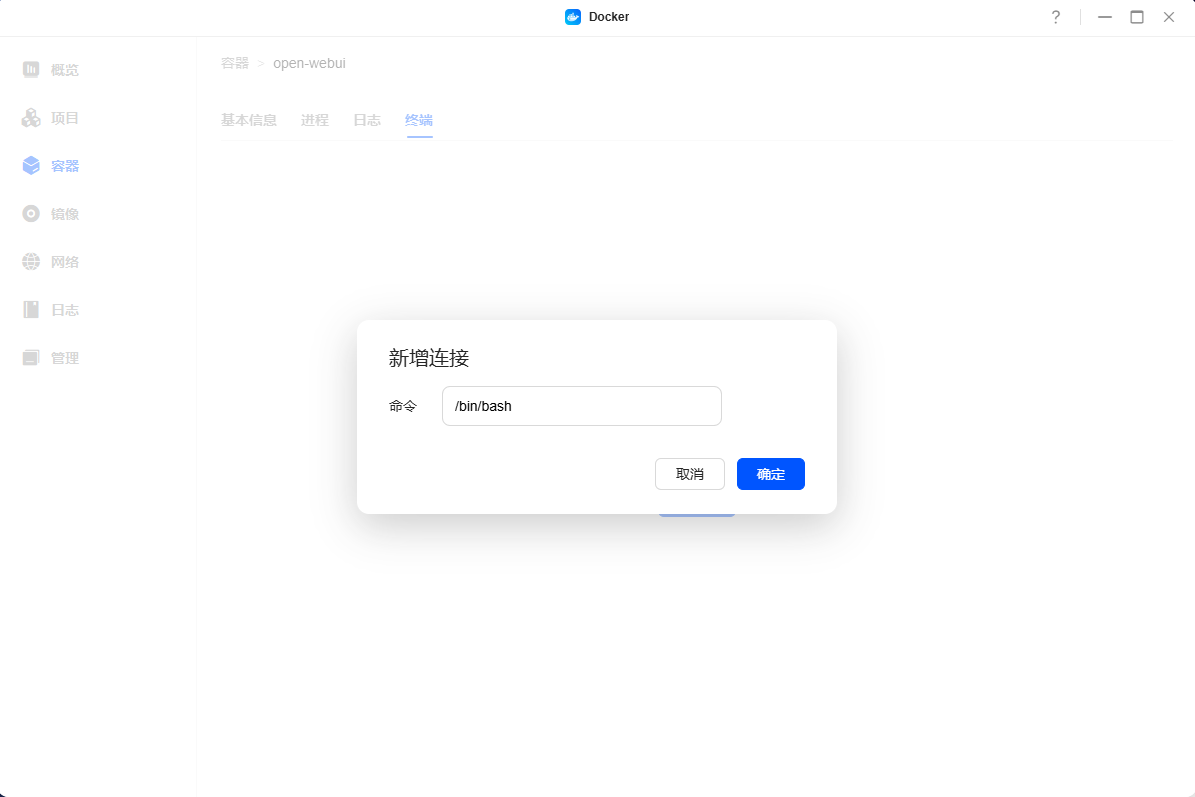

(可选)或返回 UGOS Pro 的 Docker 应用,进入【容器】 > 选中 Open WebUI 容器 > 点击【终端】 > 新增 Bash 连接。

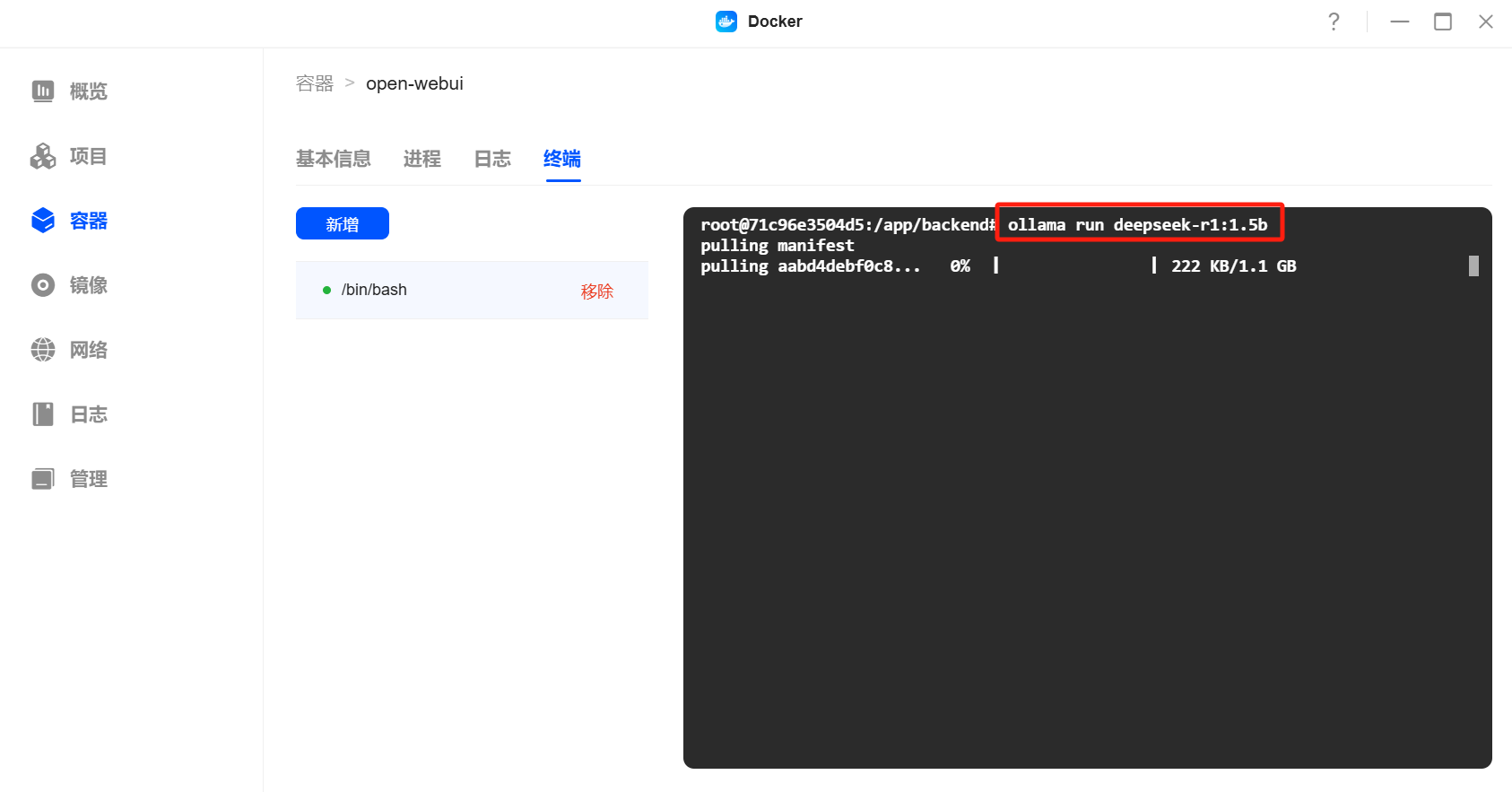

(可选)在 Bash 终端中粘贴拉取命令,等待模型下载完成。

ollama run deepseek-r1:1.5b

(可选)显示 success 说明模型下载完成,重启容器。

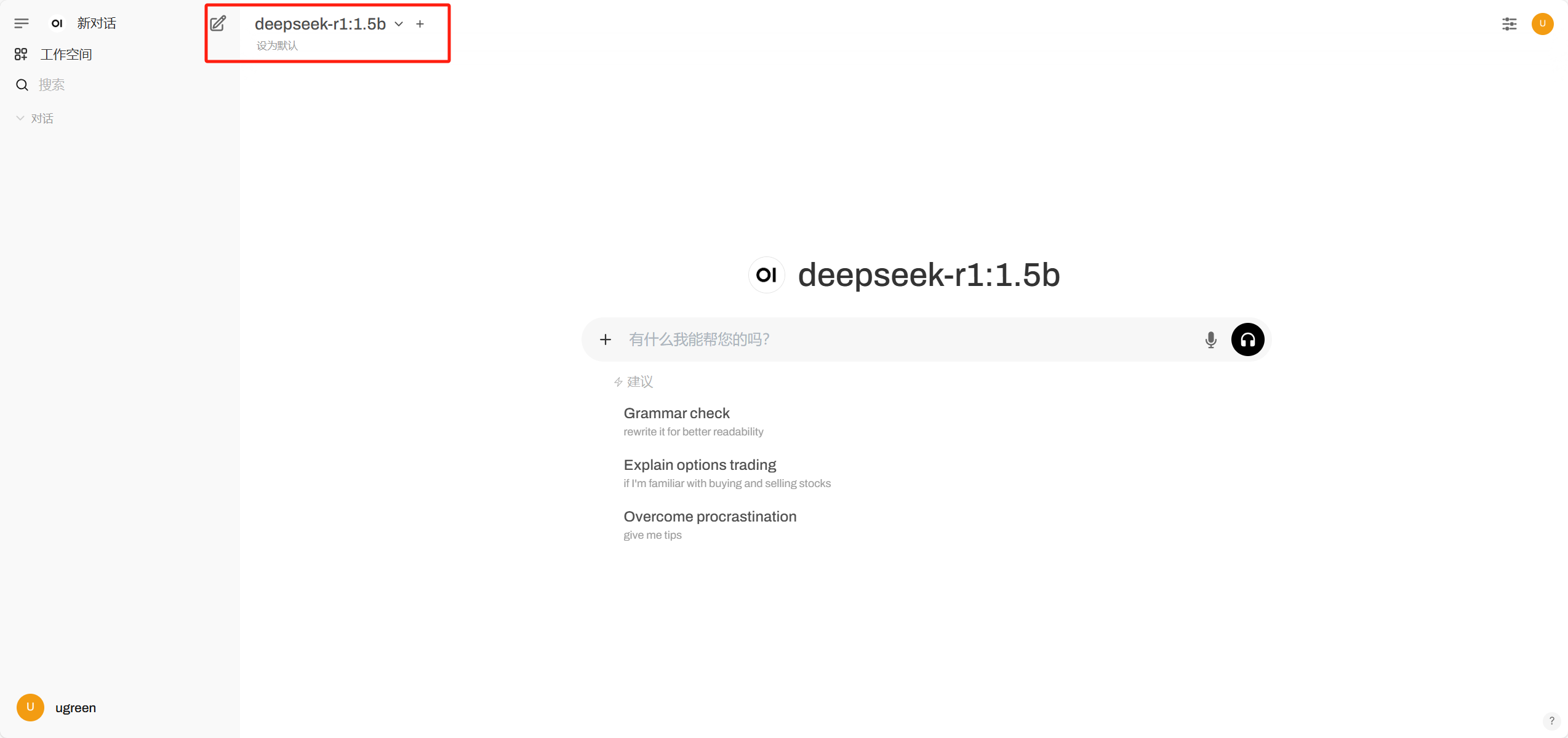

(可选)登录 Open WebUI,确认模型是否已加载。

在新对话中使用模型,输入“ hello world! ”或其他问题,可以看到已经能使用了。

请注意:部署大模型会显著增加 NAS 的 CPU 和内存负载,建议避免在高负载任务中使用。

请注意,本教程中的镜像由第三方开发和维护,教程仅供参考。绿联不承担因用户操作不当、第三方软件漏洞或镜像更新引发的风险,包括但不限于:

· 第三方镜像可能导致您在 UGOS Pro 系统中的文件意外修改或删除。

· 使用不安全的镜像可能导致数据上传至第三方服务器,存在隐私和数据泄露风险。

· 为确保系统稳定和数据安全,请谨慎选择可信来源的第三方镜像。

其他注意事项:

1. 容器的文件/文件夹路径仅供参考,您可以根据个人习惯创建。

2. 网页访问的容器端口和本地端口应保持一致。如有冲突,请改为未使用的端口。容器之间的本地端口不能相同,端口冲突会导致无法启动容器。

3. 容器的网页链接仅在 bridge 桥接模式下可访问。

4. 镜像仅提供搭建教程,具体使用方法和深度玩法请网上搜索参考。

5. 镜像由第三方开发,具体配置变动和 bug 修复请关注相关官方信息。

6. 建议将 Docker 配置目录存储在 SSD 硬盘中,以避免机械硬盘影响系统性能。